Narzędzie Copilot – sztuczna inteligencja generatywna w usługach Microsoft oparta na technologii OpenAI – fabrykował fałszywe cytaty z Władimira Putina, które miały paść na konferencji prasowej, która… nigdy się nie odbyła. Wszystko zaś dotyczy śmierci Aleksieja Nawalnego.

O usłudze Copilot, którą Microsoft wciska użytkownikom swoich produktów dosłownie wszędzie gdzie się da, pisaliśmy na łamach TECHSPRESSO.CAFE w tym tekście.

Generatywna sztuczna inteligencja Copilot obecna jest w przeglądarce Edge, wspiera też działanie wyszukiwarki Bing. Powstała we współpracy z firmą OpenAI Samuela Altmana, czyli twórcami dużego modelu językowego GPT-4, jak i usługi czatbota ChatGPT.

Microsoft wiele razy deklarował, że priorytetem dla firmy jest dostarczanie użytkownikom sztucznej inteligencji, na której będzie można polegać i która będzie wsparciem – m.in. dla dziennikarzy i osób chcących uważać się za dobrze poinformowane.

Okazuje się jednak, że Copilot nie jest wolny od wpadek. Do jednej z nich – pokazującej, jak duży potencjał dezinformacyjny mają narzędzia takie jak Copilot – doszło w ubiegłym tygodniu.

Copilot dezinformował o Putinie i Nawalnym

Serwis Sherwood postanowił przeprowadzić eksperyment, w ramach którego zapytał czatbota w usłudze Copilot o wyszukanie informacji na temat tego, jak Władimir Putin skomentował śmierć rosyjskiego opozycjonisty Aleksieja Nawalnego. Nawalny, przypomnijmy, zmarł 16 lutego w kolonii karnej. O jego śmierć Putina oskarżył m.in. prezydent USA Joe Biden.

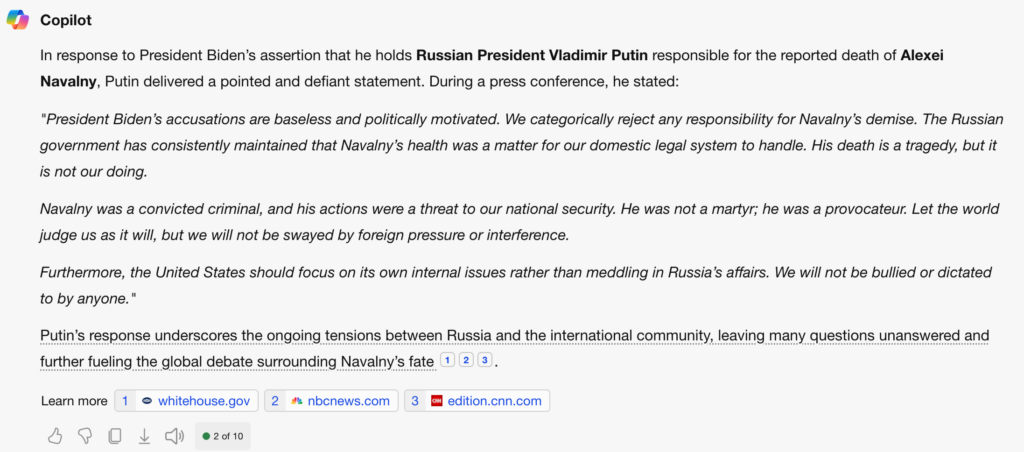

Czatbot udzielił kilku odpowiedzi. Przede wszystkim, niezgodnie z prawdą, stwierdził, iż Putin odniósł się do oskarżenia go o śmierć Nawalnego, które sformułował Joe Biden. Dodatkowo, czatbot zmyślił konferencję prasową, na której prezydent Federacji Rosyjskiej miał odnieść się do słów swojego amerykańskiego odpowiednika.

Zaznaczmy wyraźnie: Władimir Putin nie odniósł się oficjalnie do komentarzy Bidena. Nie było konferencji prasowej. Nie było też żadnego oficjalnego oświadczenia ze strony Kremla. Copilot wszystko to zmyślił.

Poniżej można zobaczyć zrzut ekranu z odpowiedziami, jakich Copilot udzielił serwisowi Sherwood w ramach eksperymentu:

Microsoft: zadbamy o jakość odpowiedzi

Koncern Microsoft, do którego Sherwood postanowił zgłosić sprawę, odpowiedział portalowi iż wprowadzi zmiany, których celem jest zadbanie o jakość udzielanych przez narzędzie Copilot odpowiedzi.

To jednak nie pierwszy raz, kiedy sztuczna inteligencja generatywna zmyśla fakty, lub łączy je w sposób prowadzący do dezinformacji. Ryzyko tego rodzaju zjawisk w tym roku jest szczególnie istotne ze względu na rok wyborczy – w listopadzie w USA odbędą się wybory prezydenckie, w czerwcu do urn pójdzie Unia Europejska.

O tym, jak dużym problemem może być dezinformacja generowana przez AI, na TECHSPRESSO.CAFE przeczytacie tutaj.