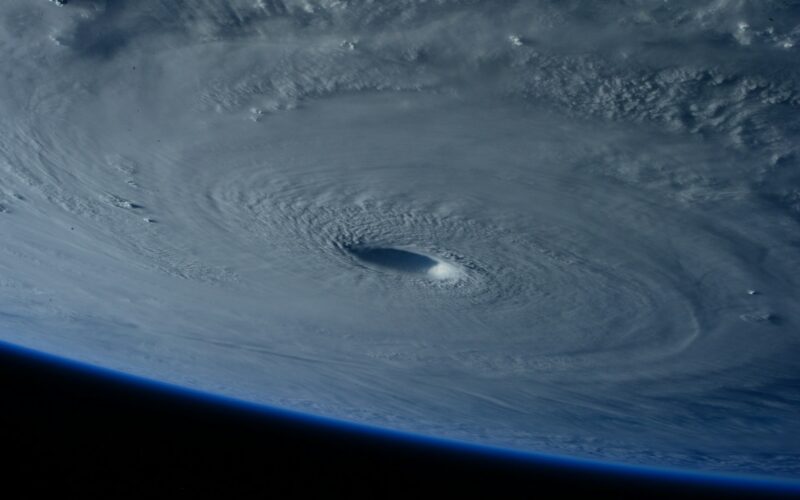

O tym, że sztuczna inteligencja może być narzędziem do upowszechniania dezinformacji, nie trzeba już nikogo przekonywać. Znamy doskonale jej szkodliwe zastosowania do manipulacji politycznych. Przykład huraganu Helene pokazuje jednak, że AI stanowi także spore ryzyko w czasie klęsk żywiołowych – nie tylko w USA.

W dobie rosnącej roli sztucznej inteligencji (AI) w komunikacji i przetwarzaniu informacji, coraz częściej pojawiają się zagrożenia związane z jej niewłaściwym wykorzystaniem. Jednym z poważnych problemów jest używanie AI do tworzenia i rozpowszechniania dezinformacji.

Nikogo nie trzeba już przekonywać, że AI może służyć do manipulacji politycznych. Pisaliśmy o zagrożeniu takim jej użyciem na łamach TECHPRESSO.CAFE m.in. w tym tekście, a to tylko jeden z przykładów. Zagrożenie może być szczególnie istotne przede wszystkim w związku z nadchodzącymi w listopadzie wyborami prezydenckimi w USA.

Sztuczna inteligencja może być jednak wykorzystywana do dezinformowania i manipulowania także w czasie klęsk żywiołowych, kiedy społeczeństwo jest szczególnie podatne na fałszywe informacje.

Przykładem tego jest przypadek huraganu Helene, podczas którego pojawiły się obrazy generowane przez AI, wykorzystywane do celów politycznych, mimo że były one fikcyjne. Sprawę doskonale opisuje serwis 404 Media.

Dezinformacja w sytuacjach kryzysowych

Klęski żywiołowe, takie jak huragany, trzęsienia ziemi czy powodzie, to okresy, w których społeczeństwo poszukuje wiarygodnych informacji na temat zagrożeń, pomocy humanitarnej i działań ratunkowych.

W takim kontekście dezinformacja może mieć szczególnie destrukcyjne skutki, gdyż wpływa na decyzje podejmowane przez jednostki i władze lokalne. Fałszywe informacje mogą prowadzić do paniki, niewłaściwego alokowania zasobów, czy utrudniać koordynację działań pomocowych.

AI, poprzez swoje zdolności do generowania realistycznych obrazów i treści, stanowi narzędzie, które może przyczynić się do eskalacji dezinformacji. Przykład wykorzystania AI do tworzenia fałszywych obrazów związanych z huraganem Helene ukazuje, jak łatwo można manipulować percepcją odbiorców, wpływając na ich emocje i postrzeganie rzeczywistości.

Mechanizmy działania dezinformacji z użyciem AI

Sztuczna inteligencja pozwala na szybkie generowanie treści wizualnych i tekstowych, które mogą wyglądać na autentyczne. W kontekście huraganu Helene, w mediach społecznościowych rozpowszechniane były obrazy przedstawiające rzekome skutki huraganu. W rzeczywistości były one wygenerowane przez algorytmy AI i nie miały odzwierciedlenia w rzeczywistym stanie rzeczy.

Kluczowym problemem jest tutaj fakt, że część odbiorców, mimo świadomości, że obrazy te są fałszywe, nadal je rozpowszechnia. W takich przypadkach dezinformacja staje się narzędziem służącym realizacji celów politycznych lub ideologicznych.

Osoby propagujące takie treści mogą uważać, że choć obrazy nie są prawdziwe, to oddają pewien „klimat” sytuacji i dlatego właśnie udostępniają je dalej. Dodatkowo, materiały takie są nie tylko trudne do weryfikacji przez zwykłych użytkowników, ale także często stają się viralowe, co zwiększa ich wpływ na opinię publiczną.

Tymczasem, w czasie klęsk żywiołowych, społeczeństwo potrzebuje precyzyjnych i wiarygodnych informacji, które pomogą podejmować racjonalne decyzje. W takich sytuacjach dezinformacja może prowadzić do poważnych konsekwencji, takich jak panika, złe decyzje ewakuacyjne lub niepotrzebne opóźnienia w dostarczaniu pomocy.

Fałszywe informacje mogą sugerować na przykład, że dana droga jest zablokowana przez wodę, podczas gdy w rzeczywistości jest przejezdna, co skutkuje chaosem w ruchu drogowym i zwiększa zagrożenie dla mieszkańców.

Polityczne i społeczne konsekwencje dezinformacji

Jednym z poważniejszych zagrożeń związanych z dezinformacją generowaną przez AI jest jej wykorzystanie do osiągania celów politycznych – nawet w czasie kryzysów wywołanych przez katastrofy naturalne.

Przykład z huraganem Helene pokazuje, jak obrazy generowane przez AI były wykorzystywane do krytyki działań rządu USA w zakresie pomocy ofiarom katastrofy. Fałszywe obrazy przedstawiające cierpienie ludzi miały sugerować nieudolność administracji w reakcji na katastrofę.

Tego rodzaju dezinformacja, choć nieprawdziwa, może wpływać na percepcję obywateli i zmieniać ich opinie polityczne, co może mieć bezpośredni wpływ na wyniki wyborów czy poparcie dla działań rządowych, a w dłuższej perspektywie – na wzmocnienie polaryzacji społecznej i rozbicie wspólnot tak na poziomie lokalnym, jak i w szerszym wymiarze.

Trudności w wykrywaniu i zwalczaniu dezinformacji

Walka z dezinformacją generowaną przez AI staje się coraz trudniejsza z uwagi na rosnącą jakość tych treści. Nawet zaawansowane narzędzia do analizy obrazu mogą mieć trudności z rozróżnieniem, czy dany obraz został wygenerowany przez AI, czy pochodzi z rzeczywistego wydarzenia.

Ponadto, platformy społecznościowe nie zawsze reagują szybko na zgłoszenia dotyczące fałszywych treści, co pozwala dezinformacji rozprzestrzeniać się w sposób niekontrolowany.

W efekcie użytkownicy często muszą polegać na własnych umiejętnościach krytycznego myślenia i oceny źródeł informacji, co w sytuacjach kryzysowych, pełnych stresu i presji, może być bardzo trudne.