Algorytmy firmy OpenAI – twórców słynnego modelu ChatGPT – szkolą się na tekstach z mediów, takich, jak np. dziennik „Wall Street Journal” czy strona internetowa stacji CNN. To duży problem – i nie chodzi tu wyłącznie o licencje na treści czy pieniądze.

„Każdy, kto chce wykorzystywać pracę dziennikarzy Wall Street Journal do trenowania sztucznej inteligencji, powinien pozyskać na to właściwą licencję od firmy Dow Jones” – powiedział cytowany przez agencję Bloomberga prawnik tej należącej do potężnego koncernu medialnego News Corp spółki, Jason Conti.

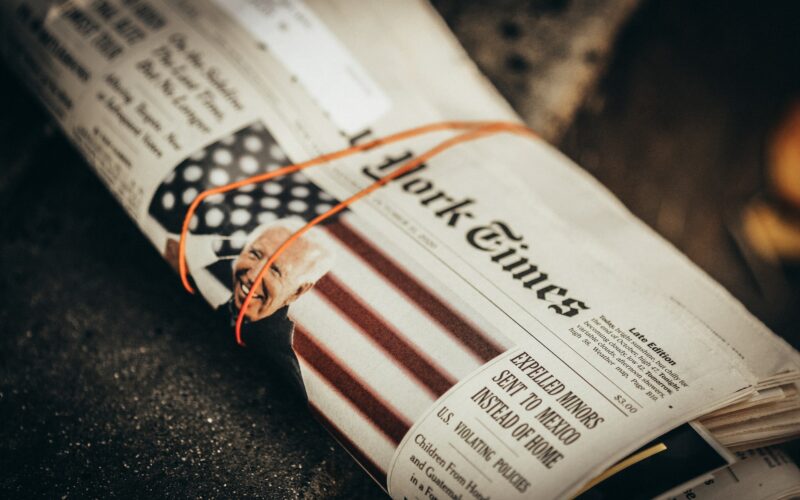

„Wall Street Journal” i 19 innych redakcji, w tym stacja telewizyjna CNN, uważają że ich materiały wykorzystywane są przez firmę OpenAI do szkolenia algorytmów wchodzących w skład modelu ChatGPT, doskonale imitującego tekst pisany przez człowieka.

Conti dodaje, że Dow Jones nie ma obecnie żadnej umowy podpisanej z OpenAI, która umożliwiałaby firmie pozyskiwanie takich licencji, a „nadużycia wobec pracy dziennikarzy są brane na poważnie”. Jak podkreśla prawnik, wydawca „WSJ” „przygląda się tej sytuacji”.

Media – żerowisko dla sztucznej inteligencji

Cała sprawa zaczęła się od wpisu dziennikarza Francesca Marconiego, który stwierdził, że ma dowody na to iż m.in. jego praca (oraz dorobek innych dziennikarzy) została wykorzystana do trenowania ChatGPT.

Marconi powiedział przy tym, że zapytał ten model o listę serwisów informacyjnych, na podstawie których był trenowany – i bez problemu uzyskał odpowiedź, w ramach której generatywna sztuczna inteligencja podała mu 20 różnych serwisów.

Zapytana o komentarz przez Bloomberga firma OpenAI do tej pory nie odniosła się do sprawy.

Internet pełen padliny

Wydawcy medialni to kolejna grupa podmiotów zaniepokojona tym, jak generatywna sztuczna inteligencja traktuje (a raczej, całkowicie ignoruje) kwestie praw autorskich i towarzyszących im praw pokrewnych.

Treści z otwartych serwisów informacyjnych, takich jak TECHSPRESSO, ale i strony agencji Associated Press, czy agencji Reutera, pobierane są przez firmy trenujące swoje algorytmy w ramach praktyki scrappingu, czyli masowego gromadzenia danych z otwartych źródeł w sieci. To praktyka legalna, niestety – wątpliwa etycznie.

Wskazywali już na to artyści wizualni, tacy jak graficy cyfrowi i fotografowie, którzy w obrazach generowanych przez słynny model Midjourney znaleźli ślady swojego stylu i podkreślają, że algorytm ten karmi się ich pracą, nierzadko stanowiącą dorobek życia prezentowany w ramach cyfrowego portfolio – a następnie generuje łudząco podobne obrazy, które po prostu są sztucznie wytworzoną imitacją, dodatkowo powstałą w wyniku naruszeń praw własności intelektualnej.

Czy sztuczna inteligencja zastąpi dziennikarzy?

To pytanie, które w kontekście rozmów o AI przewija się najczęściej – w różnych odmianach, bo przecież debatujemy też nad tym, czy przez algorytmy przestaną być potrzebni prawnicy, artyści wizualni, a nawet muzycy.

Niektóre tytuły – jak ostatnio w Polsce portal Interia – testują różne zastosowania sztucznej inteligencji. W USA, serwis technologiczny Cnet korzystał z algorytmów do generowania krótkich informacji na tematy gospodarcze, podobnie gazeta „Men’s Journal” – jednak za każdym razem teksty „pisane” przez sztuczną inteligencję były pełne błędów i wymagały od redakcji korekty, a w przypadku Cnetu – przeproszenia odbiorców, że nie przyznano się wcześniej do korzystania z algorytmów i teksty przez nie tworzone podpisywano po prostu „Redakcja”, stwarzając iluzję, że stoi za nimi „autor białkowy”.

Sztuczna inteligencja nie zastąpi zatem – powiedzmy sobie uczciwie – dobrych dziennikarzy (można mieć wątpliwości co do mediaworkerów). Nie wyłapuje wielu subtelności językowych, nie przekazuje faktów (nie do tego została stworzona, ale po to, aby brzmieć przekonująco).

Pulpa informacyjna i treści za paywallem

Jeśli algorytmy generatywnej sztucznej inteligencji będą na tyle dobre w tworzeniu treści, że – tak jak w przypadku redakcji serwisu BuzzFeed – będą zastępowały mediaworkerów zajmujących się tworzeniem najprostszych komunikatów, przeciętny czytelnik nie odczuje różnicy.

Różnicę odczują jednak ci, którzy polegają na wielu otwartych, ale rzetelnych źródłach informacji – jak choćby publicznie dostępne strony agencji informacyjnych czy dostępne w sieci artykuły mediów takich, jak choćby dziennik „Guardian”.

Dlaczego?

Media te, nie chcąc być żerowiskiem dla sztucznej inteligencji, będą powoli ogradzać się murami – i to literalnie, bo właśnie taką funkcję będą pełniły paywalle (sic!). Nawet, jeśli treści nie będą kosztowały bardzo niewiele – to będą płatne.

Sztuczna inteligencja zmieni więc raz na zawsze model internetu, w którym wiedza dostępna jest dla każdego, gdy mówimy o mediach z misją edukacyjną taką, jak ta towarzysząca TECHSPRESSO – wsparcie projektu jest dobrowolne w ramach platformy Patronite, a treści z niej dostępne są i tak dla wszystkich, nawet, jeśli nie chcą wesprzeć jej działalności, lub aktualnie nie mogą sobie na to pozwolić.

Wartościowe treści będą płatne – w tej części sieci, w której wciąż będą dostępne bezpłatne artykuły i inne materiały, będziemy mieli do czynienia najprawdopodobniej z gorszą niż obecnie pulpą informacyjną, którą wydawcy spiszą na straty – wiedząc, że to właśnie na niej karmić będą się algorytmy.

Jak Uroboros, zaczną tym samym w końcu pożerać własny ogon – bo łatwo można się domyśleć, że bezpłatne pozostaną przede wszystkim te teksty, które generuje „autor cyfrowy”. Ten „białkowy” wciąż będzie analizował, myślał i czuł – i będzie za to chciał być należycie wynagradzany, jednocześnie zachowując godność i nie stając się padliną, na której karmią się duże modele językowe.

Bardzo celnie Gosia, zgoda co co ryzyka jakie niesie dziś “dowolny wypas” algorytmów AI na treściach jakościowych. Znowu nie wszyscy widzą właściwą perspektywą i dyskusja w wielu miejscach toczy się obok problemu.